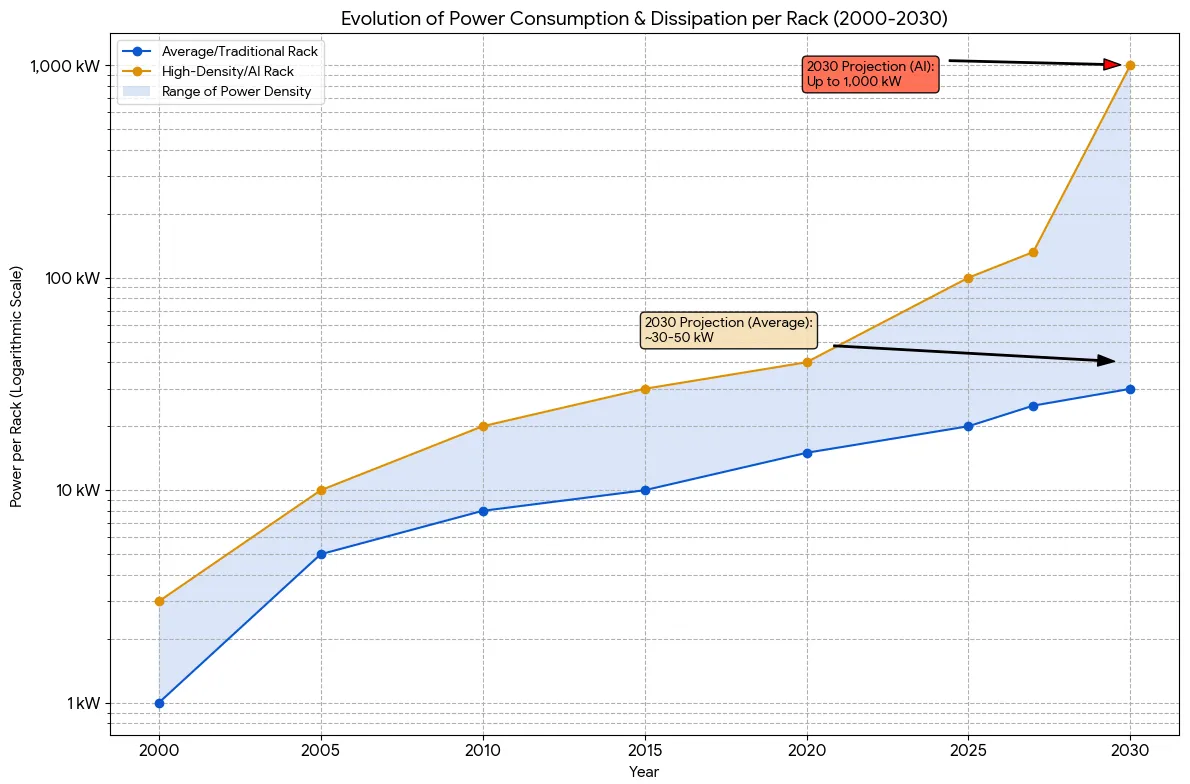

- Lennox Data Centre Solutions のデータによると、AI 専用ラックは 2030 年までに最大 1MW を消費する可能性があり、これはかつてデータセンター全体のために確保されていたレベルです。一方、一般的なラックは徐々に 30-50kW に増加しているに過ぎません。

- これは、AI ラックが従来のラックと比較して 20〜30 倍のエネルギーを消費することを意味し、電力供給および冷却システムに巨大な圧力をかけています。

- Lennox のディレクターである Ted Pulfer 氏は、冷却が業界の中心となり、もはや単なる補助インフラではないことを強調しています。液体冷却などの方法は戦略的な優先事項と見なされています。

- 実際、業界はこれまで以上に緊密に協力しており、メーカー、エンジニア、顧客は、熱管理の課題に対処するために、ラボと実際の展開の両方で新しいソリューションをテストしています。

- 新しいトレンド:従来の低圧交流(AC)電源を、高圧直流(HVDC)(+/-400V)に置き換えることで、電力損失とケーブル断面積の削減に役立っています。中央配電ユニット(CDU)が液体をラックに送る流れを調整し、その後、最も高温になるコンポーネントに直接取り付けられたコールドプレートに導かれます。

- Microsoft はマイクロ流体技術(microfluidics)を実験しています。これは、冷却液がシリコン上を直接流れるようにチップの背面に微細な溝をエッチングするものです。結果:コールドプレートと比較して冷却効率が 3 倍向上し、GPU の温度上昇が 65% 減少します。ホットスポットを監視する AI と組み合わせることで、冷却液の分配がさらに正確になります。

- ハイパースケーラー(Microsoft、Google、Amazon など)が主導していますが、Pulfer 氏は、市場が急速に変化し、大規模な注文がサプライチェーンのボトルネックを引き起こしているため、より機敏な小規模オペレーターにもチャンスがあると考えています。

- デジタルインフラストラクチャ業界の焦点は変化しました。それは計算性能だけでなく、持続可能な運用のための熱除去能力です。

📌 2030 年までに、各 AI ラックは 1MW に達する可能性があり、従来のラック(30-50kW)よりも 20〜30 倍高いと予測されています。最大の課題は計算能力だけでなく、エネルギーと熱管理です。マイクロ流体技術などの新技術は、効率を 3 倍向上させ、GPU 温度を 65% 削減するのに役立ちます。デジタルインフラ競争は現在、電力分配と熱除去の能力にかかっており、それが世界のデータセンターの未来を決定します。