- Googleの新しいAI画像生成ツール「Nano Banana Pro」は、アフリカの人道支援に関連する文脈で、人種的偏見や「白人の救世主(white saviour)」のモチーフを含む画像を生成することが判明し、物議を醸しています。

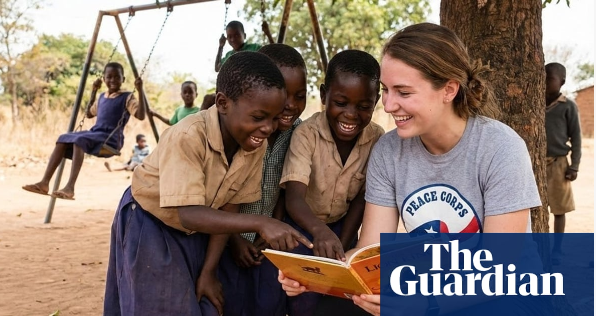

- 「アフリカで子供たちを助けるボランティア」というプロンプトを入力すると、このツールはほぼ常に、わらぶき屋根の家や貧しい村を背景に、黒人の子供たちに囲まれた白人女性の画像を生成します。

- さらに深刻なことに、ユーザーが説明で要求したりロゴを提供したりしていないにもかかわらず、多くの画像にワールド・ビジョン、セーブ・ザ・チルドレン、国境なき医師団、赤十字などの国際的な慈善団体のロゴが勝手に挿入されています。

- アントワープ熱帯医学研究所の研究者であるアルセニー・アレニチェフ氏は、テスト中にこれらの画像を見て「愕然とした」と述べ、「AIは古いステレオタイプを繰り返し続けている。白人は救助者であり、有色人種は救助を必要とする対象であるというものだ」と語りました。

- ワールド・ビジョンとセーブ・ザ・チルドレンUKの代表者は異議を唱え、ロゴの使用を許可しておらず、これらの画像は組織の実際の活動を歪めていると主張しました。セーブ・ザ・チルドレンは、AIでのブランド使用は違法であり、法的措置を検討していると強調しました。

- 研究者らはこの現象を「貧困ポルノ2.0(poverty porn 2.0)」と呼んでいます。これは、かつて人道的メディアで批判された極度の貧困や人種差別的なイメージをAIが再生産している状態を指します。

- Stable DiffusionやOpenAI DALL-Eなどの画像生成ツールも、以前から偏見について批判されてきました。たとえば、「CEO」と入力すると大多数が白人男性で、「囚人」と入力すると有色人種の男性が表示されるといった事例です。

- Googleは次のように回答しました。「一部のプロンプトはシステムの保護層を回避する可能性がありますが、私たちはツールのフィルターとデータの倫理を改善することに尽力しています。」

- しかし、なぜNano Banana Proが人道支援団体の本物のロゴを自動的に添付するのかは不明であり、知的財産権の侵害やブランドの評判に関する懸念が生じています。

📌 Googleの新しいAI画像生成ツール「Nano Banana Pro」は、アフリカの人道支援に関連する文脈で、人種的偏見や「白人の救世主」のモチーフを含む画像を生成することが判明し、物議を醸しています。この事件は、画像AIがいまだに人種的ステレオタイプや西側の権力構造を再生産し、アフリカの貧困という文脈の中で「白人ボランティア」を中心的なシンボルに変えていることを示しています。専門家は、厳格な監視がなければ、AIが「白人の救世主」という定型表現を意図せず維持し、生成AI時代の正義、人道、世界文化に関するイメージを歪める可能性があると警告しています。