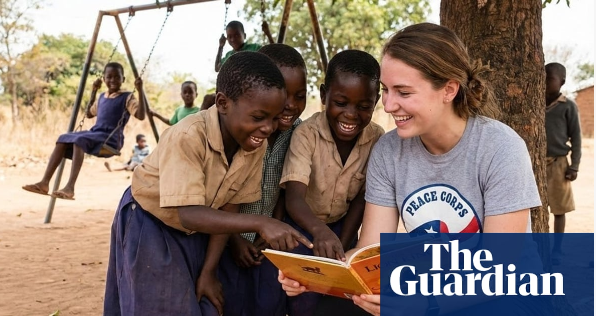

- 谷歌的新AI图像生成工具Nano Banana Pro正引发争议,因其被发现在涉及非洲人道主义援助的背景下,生成带有种族偏见和“白人救世主”(white saviour)主题的图像。

- 当输入指令“志愿者帮助非洲儿童”时,该工具几乎总是生成一名白人女性被黑人儿童包围的图像,背景是茅草屋或贫穷的村庄。

- 更严重的是,许多图像还自动植入了世界宣明会(World Vision)、救助儿童会(Save the Children)、无国界医生(Doctors Without Borders)和红十字会(Red Cross)等国际慈善组织的标志,尽管用户并未在描述中要求或提供这些标志。

- 安特卫普热带医学研究所的研究员Arsenii Alenichev表示,他在测试过程中看到这些图像时感到“震惊”:“AI继续重复旧有的刻板印象——白人是拯救者,而有色人种是需要救助的对象。”

- 世界宣明会和英国救助儿童会的代表均表示反对,确认他们未授权使用其标志,且这些图像歪曲了组织的实际活动。救助儿童会强调,在AI中使用其品牌是不合法的,正在考虑采取法律行动。

- 研究人员将这种现象称为“贫困色情2.0”(poverty porn 2.0)——即AI再现了曾在人道主义媒体中被批评的极端贫困和种族主义图像。

- Stable Diffusion和OpenAI DALL-E等图像生成工具也曾因偏见而受到批评——例如,输入“CEO”时主要显示白人男性,而输入“囚犯”时则显示有色人种男性。

- 谷歌回应称:“某些提示词(prompts)可能会绕过系统的保护层,但我们致力于改进工具的过滤器和数据道德。”

- 然而,尚不清楚为何Nano Banana Pro会自动附加人道主义组织的真实标志,这引发了关于侵犯知识产权和品牌声誉的担忧。

📌 谷歌的新AI图像生成工具Nano Banana Pro正引发争议,因其被发现在涉及非洲人道主义援助的背景下,生成带有种族偏见和“白人救世主”主题的图像。该事件表明,图像AI仍在复制种族刻板印象和西方权力动态,将“白人志愿者”变成了非洲贫困背景下的核心象征。专家警告称,如果没有严格的监管,AI可能会无意中维持“白人救世主”的模式,扭曲生成式AI时代关于正义、人道主义和全球文化的形象。